欢迎来到小七同学的AI课堂

今天我们来介绍下Stable Diffusion的操作界面。

首先我们通过启动器启动Stable Diffusion的Web UI, 如果不知道如何安装的同学,可以查看我们的上一期课程。

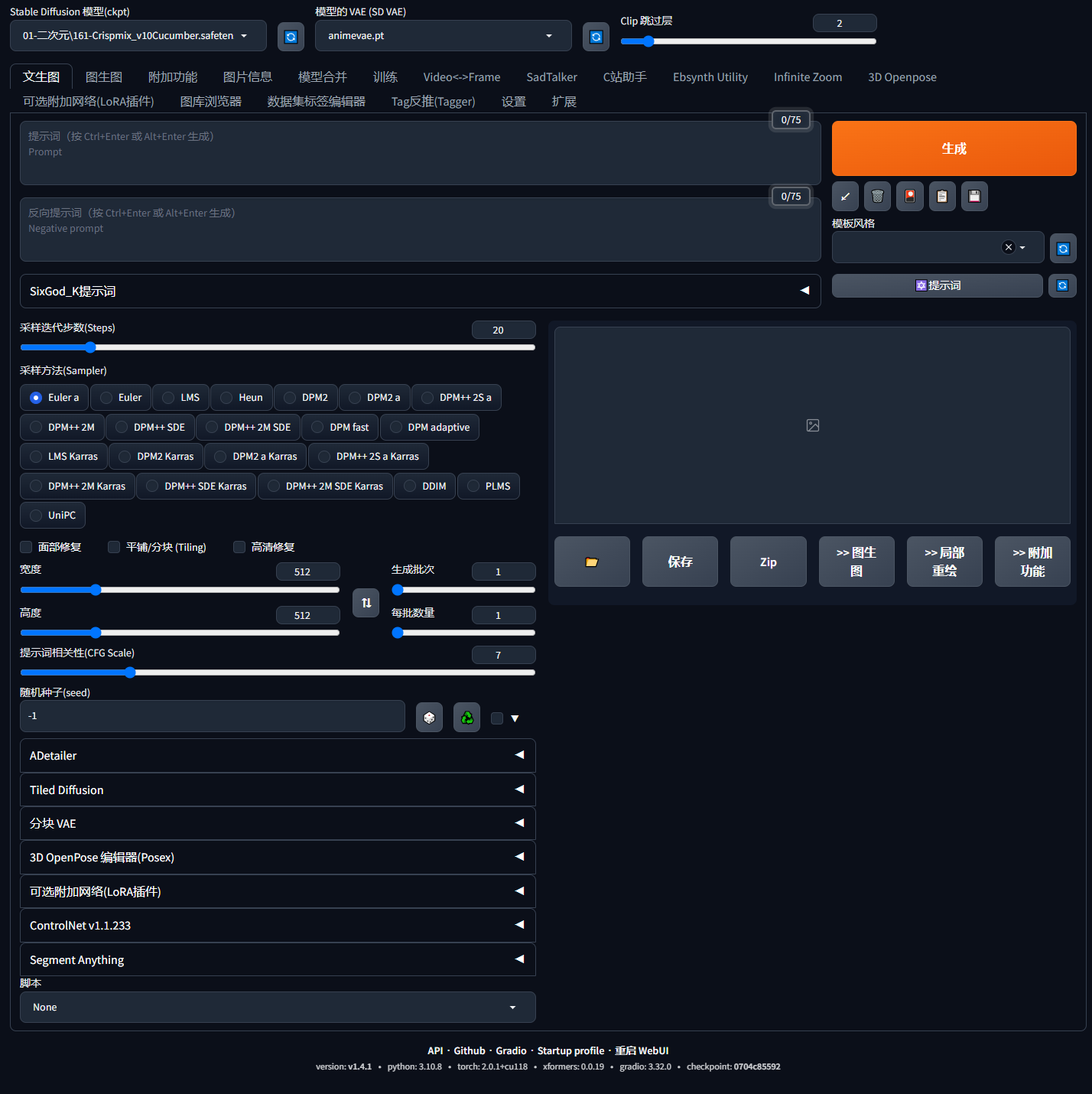

Stable Diffusion的操作界面介绍

模型选择

我们打开界面后,顶部左上角会看到一个下拉框,这个是主模型Models选择,主模型可以理解为你让AI参考的主要图片知识库,不同的主模型对于整体出图效果来说影响是比较大的,例如主模型可以区分偏二次元的动画模型,或者是偏三次元的真实模型。

如果你想要扩展你的主模型,可以把下载好的模型放到你的models,Stable-diffusion目录下,这样刷新一下就能看到你添加的模型了。

VAE选择

接下来,顶部第二个下拉框是VAE选择,我们可以将VAE理解为对模型的滤镜加微调,不同的 VAE可能有一些细节上的差异,但对输出的结果不会有较大的影响,目前主流的VAE为kl-f8-anime和vae-ft-mse,如果不会选,可以直接选择Auto即可。

Tab页签

那么接下来下面的Tab页签,则是对应了Stable Diffusion的不同功能,我们最常用的就是前两个文生图和图生图,代表的是两种绘制方式,我们会在后续课程中详细讲解。下面的附加功能,目前主要是用于图片批量处理和图片放大功能,这部分也会在后续课程详细讲解。

那么最后的两个页签,一个是设置,可以对整体Stable Diffusion的Web UI进行功能和界面设置,一个是扩展,可以安装和更新插件。

提示词Prompt

接下来,我们回到文生图,来看看操作中必备的几个界面:

第一个是提示词输入框,提示词Prompt又称之为标签,我们也可以称之为“咒语”,就是通过对图片的描述,让AI理解我们想要生成的图片,例如“一个身着白色衬衫的双马尾女孩”,我们就可以使用下列提示词“one girl, twintails,white shirt”

如果你不懂英文,那么也可以通过翻译软件,或者安装提示词相关的辅助软件来帮助你使用提示词,这个会在后面的提示词使用课程中详细讲解。

那么除了正向提示词以外,还可以输入反向提示词,这样就会告诉AI我们不想要的东西,例如我们想要生成风景图,不需要人物出现,那么就可以在反向提示词中输入“no human”来屏蔽人物。

采样配置

关键词下面就是生成图片的一些参数配置,这包括了采样迭代数,和采样方法。

不同的采样方法,对应不同的采样迭代数会有不同的效果,经过测试对比,这里推荐的采样迭代数为20-30步,推荐的采样方法为Eular a / DPM++ 2M Karras / DDIM。

输出分辨率配置

那么采样配置下方会有分辨率配置,可以配置图片尺寸,为了节省时间,我们一般采用512*512或768*768的尺寸进行跑图测试,等找到合适的图可以采用高清修复等图片放大手段进行高分辨率输出。

分辨率下方的生成批次和生成数量,是控制每次生成多少张,以及生成几次。

提示词相关性则是你的提示词在生成图片的时候的比重有多少,默认为7即可。

下面的随机种子Seed,这个参数默认为-1,则是随机出图,如果你以及输出了一张图片,那么可以按照输出图片的Seed参数来锁定这个类型的图片。

ControlNet及插件配置

最后底部还有一些插件脚本的配置选项和ControlNet配置界面,这些会在后续的课程中详细介绍。

那么,接下来我们跑一张图来试一试吧。输入正向关键词,输入反向关键词,确保其他配置参数可以默认,直接点击生成。底部可以看到图片在一步步生成,最后点击文件夹查看输出目录,也可以点击保存来保存到你需要的目录中。

结束语

好了,本期的课程就介绍到这里,我们下期课程见。